transformer使用bn还是ln,transformer为什么比lstm效果好

作者:admin日期:2024-02-10 15:00:15浏览:46分类:资讯

bert原码解析(embedding)

position embedding的lookup table 大小512*768,说明bert最长处理长度为512的句子。长于512有几种截断获取的方式。position embedding的生成方式有两种:1 根据公式直接生成 2 根据反向传播计算梯度更新。

BERT中的Embedding主要有3种:Token Embedding 是对词向量进行编码。原始的输入是[batch,seq_len]。经过 Token Embedding 后数据的维度为[batch,seq_len,d_model]。

BERT有两部分:pre-training和fine-tuning。在pre-training阶段,会在没有标注数据且不同预训练任务上训练模型;在fine-tuning阶段,BERT会根据预训练模型的参数初始化,然后在下游任务的标注数据进行fine-tuned。

bert结构大体上可分为 输入 、 N层transformer的encoder 和 输出 三部分组成。

bert的词嵌入由三个嵌入token embedding、segment embedding,和position embedding叠加而成。

Transformer解读(附pytorch代码)

1、在Transformer出现之前,RNN系列网络以及seq2seq+attention架构基本上铸就了所有NLP任务的铁桶江山。

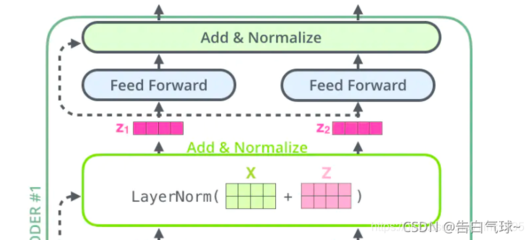

2、详解Transformer (论文Attention Is All You Need). 正如论文的题目所说的,Transformer中抛弃了传统的CNN和RNN,整个网络结构完全是由Attention机制组成。

3、对于希望自己尝试一些 3D 深度学习的 PyTorch 用户,Kaolin 库值得研究。对于 TensorFlow 用户,还有TensorFlow Graphics。一个特别热门的子领域是 3D 模型的生成。

4、PyTorch是一个非常流行的深度学习框架。但是与其他框架不同的是,PyTorch具有动态执行图,意味着计算图是动态创建的。

函数f(x)=x-ln(x+1),数列{an},满足0a11,an+1=f(an),数列{bn}满足b1=...

现在分析an + 1 = f(an)则an + 1 = an - anlnan,为了说明简便,不妨即y = an,即y + 1 = y - ylny 也就是ylny = -1。换句话说,数列{an}的所有项就是ylny = -1的所有根。不妨来分析一下这个方程。

f(x)=1/x-1=1-x/x (x0)当xfx0.f递减 当0x1,f0 f递增 x=1 f(1)=-1是最大值。

/a1=1/1=1,数列{1/an}是以1为首项,1为公差的等差数列。

已知函数f(x)=x/x+1,数列{an}满足a1=1,an+1=f(an)求证,数列{1/an}是等差数列。

湖北省100所重点中学2012届10月高三联合考试理科答案 我知道最好的是“健桥湿疹网”采纳我为最佳把,呵呵。

猜你还喜欢

- 05-30 服装设计效果图参赛作品,服装设计效果系列图

- 05-16 房屋设计效果图片素材,房屋设计效果图制作

- 05-15 房屋设计效果软件,房屋设计效果图软件

- 05-13 房屋设计图效果图大全,房屋设计效果图片

- 05-11 转角书房设计方案[转角书房书柜效果图片大全]

- 05-06 超薄低音设计方案[超薄低音喇叭效果怎么样]

- 04-29 发电玻璃设计方案[发电玻璃发电效果怎么样?]

- 04-12 轮播图怎么实现轮播效果,轮播图怎么实现的

- 04-06 javascript正则表达式教程,js 正则表达式使用

- 04-06 matlab仿真使用教程,matlab仿真教程视频

- 04-06 linux常用命令及使用,linux常用命令及使用方法

- 04-06 linux中安装软件可使用,linux中安装软件可使用什么命令

取消回复欢迎 你 发表评论:

- 最近发表

- 标签列表

- 友情链接

暂无评论,来添加一个吧。