python爬虫兼职网站,python爬虫接单网站

作者:admin日期:2024-04-11 14:30:40浏览:19分类:资讯

python网络爬虫可以干啥

1、爬虫,又叫spider,是在互联网行业抓取公开数据的一种自动化工具。在搜索、新闻资讯或电商等行业,是一种常见的获取大数据的行为。

2、数据科学 数据科学,包括了机器学习,数据分析和数据可视化。

3、说白了就是网络黄牛利用爬虫软件24小时监控某个系统,比如说苹果官网的维修预约就很难预约到,这时候就可以24小时监控他们的官网一有预约号出来立刻就用软件抢了,然后再卖出去。

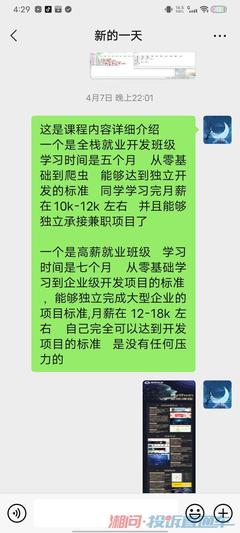

想学习下爬虫做兼职接单,猿来教育讲爬虫怎么样啊?

1、据我所知,猿来教育在这方面做得也比较不错,他们提供在线问答、作业批改、课程辅导等服务,帮助学生更好地掌握知识和技能。猿来教育的Python爬虫课程在课程内容、实战项目和教学服务等方面都做得比较好。

2、Python爬虫外包项目:想要通过网络爬虫挣钱,爬虫外包项目是非常不错的一种方法。

3、同时Python的应用也十分广泛,它具有十分丰富的第三方库,能够用于网站开发、大数据分析、人工智能开发、自动驾驶等几乎所有领域。每天5分钟,轻松学爬虫。

4、通用网络爬虫对于硬件配置的要求比较高,爬行数量和范围较大,对所爬行页面的顺序并没有太高的要求,但是由于采用并行工作方式的原因,需要很长时间才可以刷新爬行页面。

5、通过百度搜索了解该机构的口碑和师资 通过该机构的免费教程体验一下,课程质量 找到已经学习过的同学,结合自身情况深度了解一下你的需求是否可被解决。py编程课,每天5分钟,轻松学Python。

python爬虫技术有哪些做的比较好的

可以看这个教程:网页链接 此教程 通过三个爬虫案例来使学员认识Scrapy框架、了解Scrapy的架构、熟悉Scrapy各模块。此教程的大致内容:Scrapy的简介。主要知识点:Scrapy的架构和运作流程。

将所有要下载的URL存储在待处理队列中,每次下载会取出一个,队列中就会少一个。我们知道有些URL的下载会有反爬虫策略,所以针对这些请求需要做一些特殊的设置,进而可以对URL进行封装抽出 Request。

存储数据建议用mongdb数据库,都是超简单的操作。处理验证码可以训练Tesseract做到。如果网站有api的话,那将是最快速、最方便的数据采集途径了。另外,python是进行数据处理最好的编程语言了,数据的采集是数据处理的第一步。

Python适合写爬虫的原因有以下几点: 简单易学:Python语法简洁清晰,易于理解和学习,即使是没有编程经验的人也能够快速上手。

自学python可以做什么兼职

自学Python能干的副业:兼职处理数据,Python在搜集整理分析数据的过程中更加便捷;兼职查询资料,很容易通过几行代码在网络上爬取各种各样的资源;兼职P图,通过Python可以利用相关代码进行批量处理图片。

兼职P图 通过Python可以利用相关代码进行批量处理图片。不管是缩放、旋转、镜像、裁剪、灰度、添加文本等等,都可以在Python的帮助下获得,再也不用一张一张去P图了。

网络爬虫。在爬虫领域,Python几乎是霸主地位,可以将网络数据进行收集整理以及分析。这样就可以给一些客户做一些数据收集,以及自动分析的程序 2:自动化运维。

P图 通过Python可以利用相关代码进行批量处理图片,不管是缩放、旋转、镜像、裁剪、灰度、添加文本等等,都可以在Python的帮助下获得,再也不用一张一张去P图了。

如何用Python做爬虫

因此,你不需要学习怎么样“入门”,因为这样的“入门”点根本不存在!你需要学习的是怎么样做一个比较大的东西,在这个过程中,你会很快地学会需要学会的东西的。

如果你想要入门Python爬虫,你需要做很多准备。首先是熟悉python编程;其次是了解HTML;还要了解网络爬虫的基本原理;最后是学习使用python爬虫库。如果你不懂python,那么需要先学习python这门非常easy的语言。

可以用认为最快最优的办法,比如正则表达式。然后将分析后的结果应用与其他环节:)展示 要是做了一堆事情,一点展示输出都没有,如何展现价值。所以找到好的展示组件,去show出肌肉也是关键。

至此,我们就完成了利用python来爬取网页数据。

我们可以通过python 来实现这样一个简单的爬虫功能,把我们想要的代码爬取到本地。下面就看看如何使用python来实现这样一个功能。具体步骤 获取整个页面数据首先我们可以先获取要下载图片的整个页面信息。

如何利用python写爬虫程序

安装必要的库 为了编写爬虫,你需要安装一些Python库,例如requests、BeautifulSoup和lxml等。你可以使用pip install命令来安装这些库。抓取网页数据 主要通过requests库发送HTTP请求,获取网页响应的HTML内容。

编写爬虫程序:使用编程语言(如Python)编写爬虫程序,通过发送HTTP请求获取网页内容,并使用解析库(如BeautifulSoup)解析网页,提取所需数据。

利用python写爬虫程序的方法:先分析网站内容,红色部分即是网站文章内容div。

考虑如何用python实现:在各台slave上装好scrapy,那么各台机子就变成了一台有抓取能力的slave,在master上装好Redis和rq用作分布式队列。

我们可以通过python 来实现这样一个简单的爬虫功能,把我们想要的代码爬取到本地。下面就看看如何使用python来实现这样一个功能。具体步骤 获取整个页面数据首先我们可以先获取要下载图片的整个页面信息。

一般获取数据的过程都是按照 发送请求-获得页面反馈-解析并且存储数据 这三个流程来实现的。这个过程其实就是模拟了一个人工浏览网页的过程。

猜你还喜欢

- 05-05 网站社区设计方案[网站社区设计方案模板]

- 04-20 小白学python,小白学python难吗

- 04-20 scrapy爬虫实例,scrapy爬虫案例

- 04-19 python多久能学会,python多久能学会 大叶子

- 04-19 python最简单的小爬虫,python简单的爬虫程序

- 04-19 视频教程网官网,官方教学视频网站

- 04-18 java爬虫和python爬虫,爬虫和java哪个好

- 04-18 注册网址在哪里注册,注册网站的步骤

- 04-17 java的成品网站,java项目网站

- 04-13 html5网站模板怎么用,html5网站模板源码

- 04-13 做个公司网站多少钱,做个公司网站多少钱一年

- 04-13 网站开发技术有哪些,网站开发技术有哪些内容

取消回复欢迎 你 发表评论:

- 最近发表

- 标签列表

- 友情链接

暂无评论,来添加一个吧。